A Neural Algorithm of Artistic Style

논문 정보

- 제목: A Neural Algorithm of Artistic Style

- 저자: Leon A. Gatys, Alexander S. Ecker, Matthias Bethge (University of Tübingen 등)

- 학회/저널: arXiv preprint

- 발행일: 2015-09-02

- DOI: 10.48550/arXiv.1508.06576

- 주요 연구 내용: 사전 훈련된 VGG-19 네트워크를 사용하여 이미지의 콘텐츠(Content)와 스타일(Style) 표현을 분리하는 방법을 제안함. 콘텐츠는 네트워크의 상위 계층 피처 맵으로 정의하고, 스타일은 여러 계층에 걸친 피처 맵 간의 상관관계(Gram 행렬)로 정의하여 두 표현을 독립적으로 제어함.

- 주요 결과 및 결론: 사진의 콘텐츠와 명화의 스타일을 성공적으로 결합하여 높은 지각적 품질의 새로운 예술 이미지를 생성함. 이를 통해 CNN에서 콘텐츠와 스타일 표현이 분리 가능하다는 것을 입증했으며, 이는 인간의 예술 창작 및 인식 과정을 알고리즘적으로 이해하는 경로를 제시함.

- 기여점: 최초로 자연 이미지에서 콘텐츠와 스타일을 분리하는 이미지 피처를 시연함. 예술적 이미지 생성을 위한 신경망 알고리즘을 제공했으며, 예술 및 스타일에 대한 신경과학적 연구를 위한 새로운 도구를 제시함.

요약

초록

딥러닝 신경망에 기반한 인공 시스템을 소개한다. 이 시스템은 임의의 이미지의 콘텐츠와 스타일을 분리하고 재조합하여 높은 지각적 품질의 예술적 이미지를 생성하는 신경망 알고리즘을 제공한다. 이 연구는 인간이 예술적 이미지를 창작하고 인식하는 방식에 대한 알고리즘적 이해를 위한 경로를 제시한다.

서론

인간은 예술에서 콘텐츠와 스타일의 복잡한 상호작용을 통해 독특한 시각적 경험을 만들어내지만, 그 알고리즘적 기반은 알려지지 않았다. 객체 인식 등에서 뛰어난 성능을 보인 딥러닝 신경망(DNN)을 기반으로, 이미지의 콘텐츠와 스타일을 분리하고 재결합하는 인공 시스템을 제안한다.

모델 아키텍처 / 방법론

-

핵심 구조/방법: 사전 훈련된 VGG-19 네트워크를 기반으로 이미지 표현을 추출한다. 콘텐츠와 스타일을 각각 다른 방식으로 정의하고, 두 표현에 대한 손실(Loss)을 동시에 최소화하는 새로운 이미지를 생성하는 최적화 기법을 사용한다.

-

주요 구성 요소:

- 콘텐츠 표현 (Content Representation): 네트워크의 상위 계층(예: 'conv4_2')에서 얻은 피처 맵. 이미지의 전반적인 객체와 배치를 포착하지만, 픽셀 단위의 세부 정보는 잃는다.

- 스타일 표현 (Style Representation): 각 계층의 피처 응답 간의 공간적 상관관계를 나타내는 Gram 행렬. 이 행렬은 텍스처, 색상, 국소적 구조 등 이미지의 스타일 정보를 포착한다.

-

수식:

- 콘텐츠 손실: 원본 콘텐츠 이미지()와 생성 이미지()의 번째 계층 피처 표현() 간의 평균 제곱 오차.

- 스타일 손실: 원본 스타일 이미지()와 생성 이미지()의 Gram 행렬() 간의 평균 제곱 오차를 여러 계층에 대해 가중합.

- 전체 손실: 콘텐츠 손실과 스타일 손실의 가중합(, 는 가중치).

-

알고리즘: 백색 잡음(white noise) 이미지에서 시작하여, 경사 하강법(gradient descent)을 사용해 전체 손실 함수를 최소화한다. 이 과정에서 이미지 픽셀 값은 콘텐츠 이미지의 구조와 스타일 이미지의 화풍을 모두 갖도록 최적화된다.

실험 결과

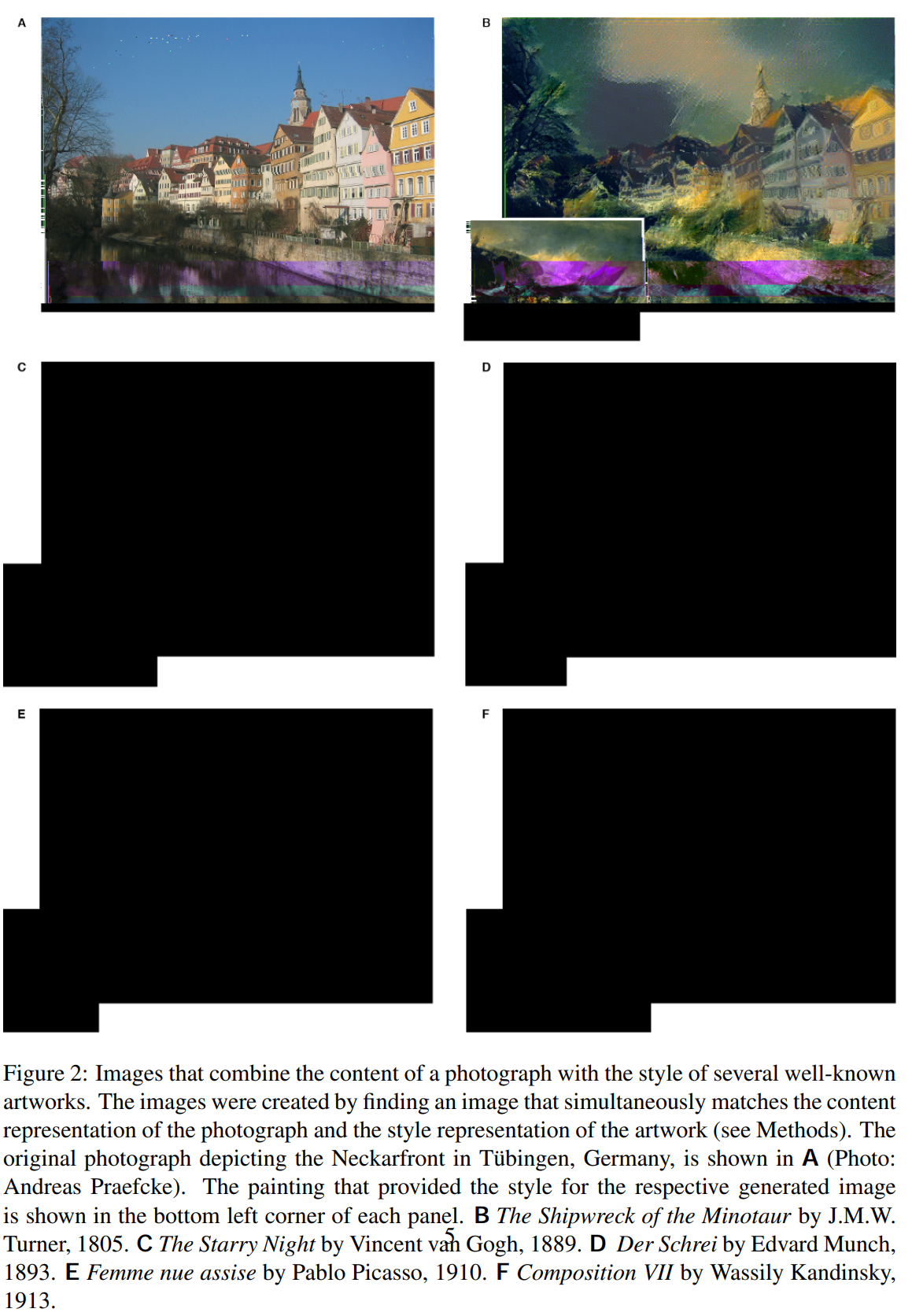

- 주요 데이터셋: 독일 튀빙겐의 "Neckarfront" 사진을 콘텐츠 이미지로, 반 고흐의 '별이 빛나는 밤', 뭉크의 '절규' 등 유명 화가들의 작품을 스타일 이미지로 사용하였다.

- 핵심 성능 지표: 생성된 이미지의 시각적 품질을 통해 정성적으로 평가했다. 논문의 Figure 2는 다양한 스타일이 사진의 콘텐츠를 유지하면서 성공적으로 적용된 결과를 보여준다.

- 비교 분석:

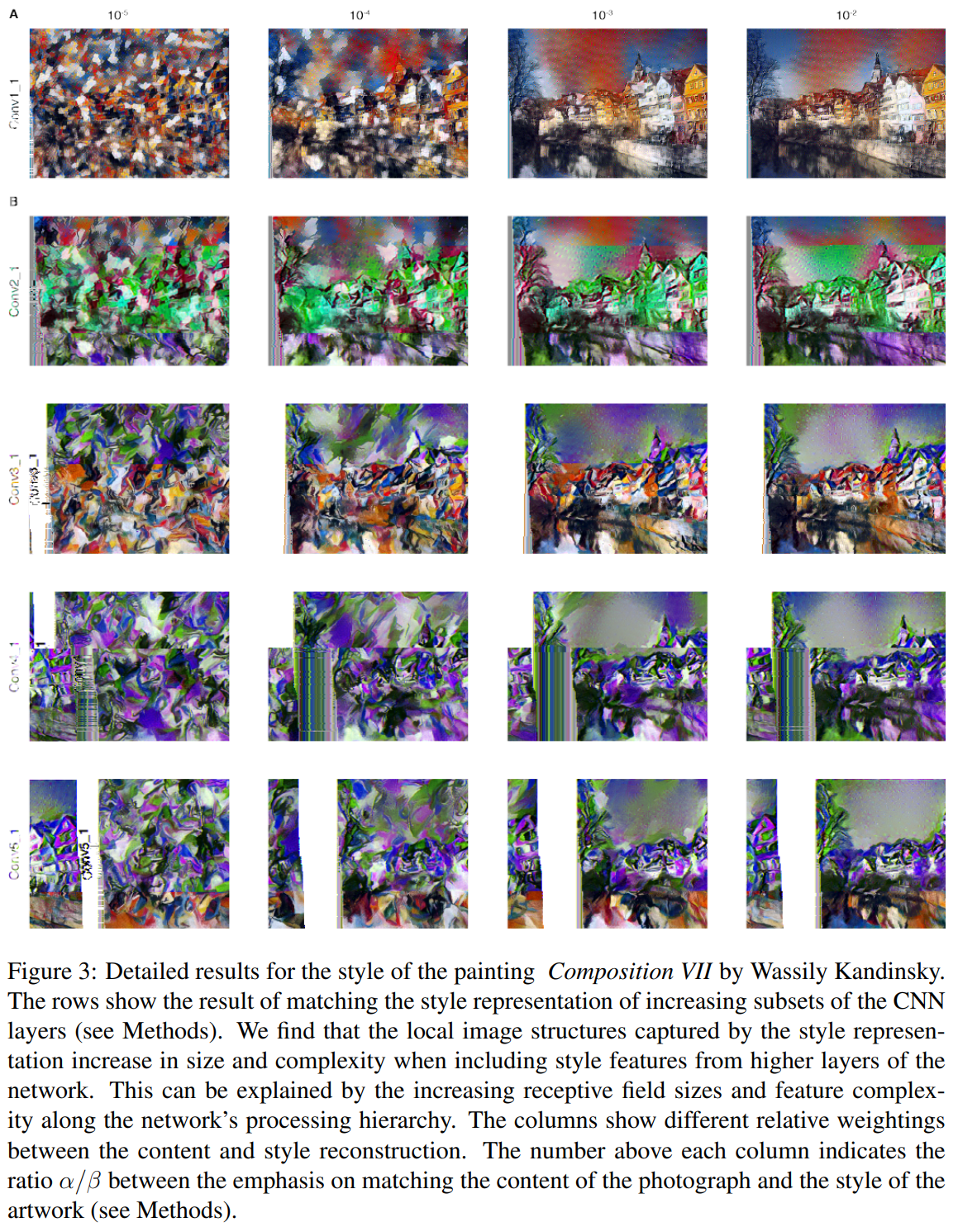

- 콘텐츠와 스타일의 가중치 비율()을 조절하여 콘텐츠 보존과 스타일 적용 강도를 제어할 수 있음을 Figure 3에서 보여주었다.

- 스타일 표현에 사용되는 CNN 계층의 깊이에 따라 스타일의 국소적/전역적 특징이 달라짐을 입증했다. 낮은 계층을 사용하면 미세한 텍스처가, 높은 계층까지 사용하면 더 크고 복잡한 스타일이 반영된다.

결론

객체 인식을 위해 훈련된 신경망이 이미지의 콘텐츠와 스타일을 분리하는 표현을 부수적으로 학습한다는 것을 보여주었다. 이 방법론은 예술적 이미지 생성을 넘어, 시각 인지 및 신경 표현 연구에 새로운 실험적 도구를 제공할 수 있는 가능성을 열었다. 이 연구는 이후 Neural Style Transfer 분야의 시초가 되었다.