Explainable machine learning in materials science

논문 정보

- 제목: Explainable machine learning in materials science

- 저자: Xiaoting Zhong, Brian Gallagher, Shusen Liu, Bhavya Kailkhura, Anna Hiszpanski, T. Yong-Jin Han (Lawrence Livermore National Laboratory)

- 학회/저널: npj Computational Materials

- 발행일: 2022-09-22

- DOI: 10.1038/s41524-022-00884-7

- 주요 연구 내용: 재료과학 분야에서 높은 정확도를 가진 머신러닝 모델의 블랙박스 문제를 해결하기 위한 설명 가능 인공지능(XAI)의 개념과 기술을 소개함. 모델 처리 과정(후처리)과 모델 설계(선행) 측면에서 DNN을 설명하는 다양한 방법을 분류하고, 실제 재료과학 응용 사례를 검토함.

- 주요 결과 및 결론: 재료과학 연구에서 XAI 기술, 특히 히트맵과 같은 시각화 기법이 모델 예측을 신뢰하고, 모델의 오류 원인을 진단하며, 새로운 과학적 가설을 생성하는 데 효과적임을 보여줌. 또한, XAI가 아직 초기 단계이며 재료과학 데이터의 명확한 정답(ground truth) 부족, 설명 평가의 어려움 등 해결해야 할 과제가 많음을 지적함.

- 기여점: 재료과학 분야 연구자들에게 XAI에 대한 입문서 역할을 제공하며, 예측 정확도뿐만 아니라 설명 가능성을 원하는 이들에게 유용한 개념적 틀과 실제 적용 사례를 제시함. 논문은 XAI 기술의 유용성을 강조하는 동시에, 무분별한 해석을 피하고 적절한 평가의 필요성을 역설함.

요약

초록

이 논문은 뛰어난 정확도 때문에 재료 연구에 점점 더 많이 활용되는 머신러닝 모델의 '설명하기 어려운' 문제에 초점을 맞춘다. 딥러닝과 같은 복잡한 모델의 설명 가능성을 다루는 새로운 연구 분야인 설명 가능 인공지능(XAI)을 재료과학자들에게 소개하는 것을 목표로 한다. 논문은 재료과학의 맥락에서 '설명'이 무엇을 의미하는지 개념을 정의하고, XAI가 재료과학 연구에 어떻게 도움이 되는지 실제 사례를 검토한다. 또한, 이 분야의 도전과 기회에 대해 논의한다.

서론

전통적인 재료과학 연구는 전문가의 지식에 크게 의존하지만, 예측 정확도와 효율성 면에서 한계가 있다. 최근 발전한 실험 및 계산 도구들은 방대한 양의 데이터를 생산하며, 이를 효율적으로 분석하고 새로운 재료를 더 빠르게 설계하기 위한 도구로 머신러닝이 주목받고 있다. 머신러닝 모델은 높은 효율성과 정확도를 보이지만, 특히 딥러닝과 같은 모델은 그 예측 과정을 이해하기 어렵다는 '블랙박스' 문제가 있다. 이러한 설명 가능성의 부족은 모델 신뢰를 저해하고 숨겨진 인과관계를 파악하거나 새로운 과학적 가설을 세우는 데 걸림돌이 된다. 이 논문은 이러한 문제를 해결하기 위한 XAI의 주요 개념, 기술, 그리고 재료과학에서의 응용 사례를 체계적으로 검토한다.

배경

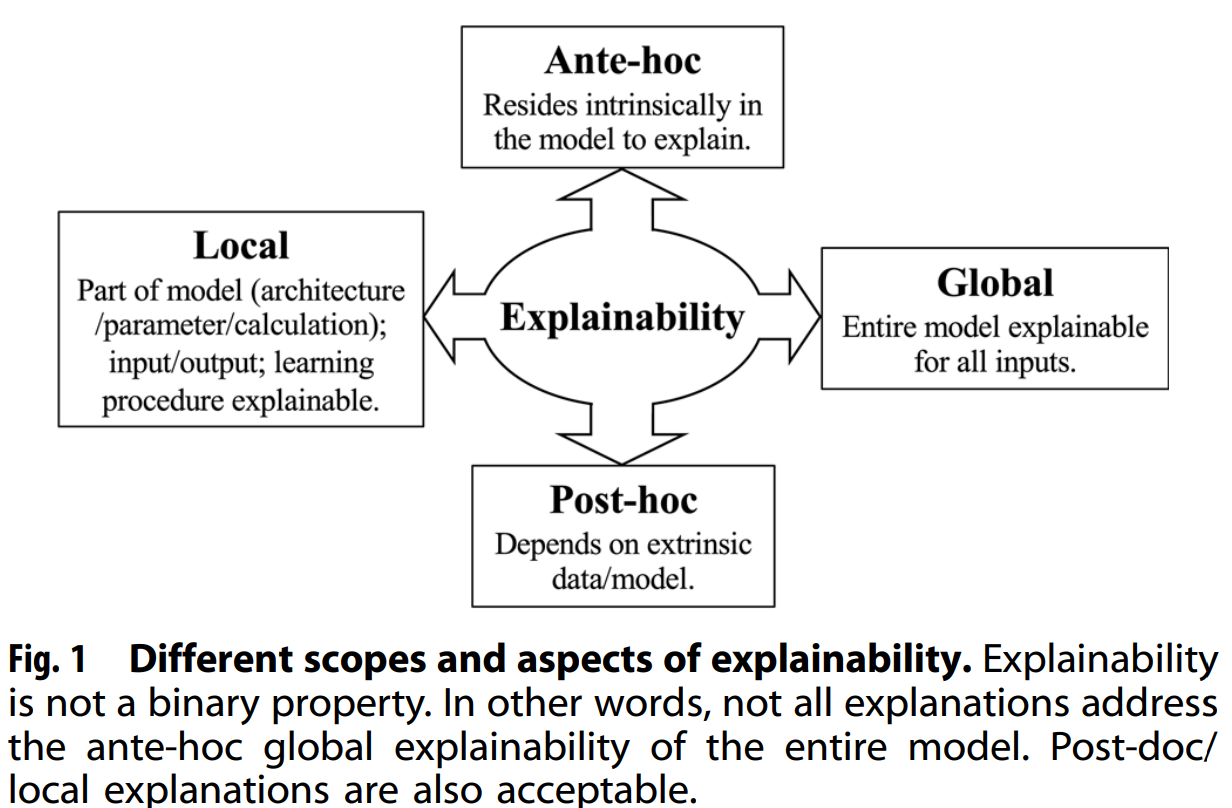

설명 가능성(explainability)은 이진 속성이 아니며 다양한 관점에서 접근할 수 있다. 논문은 Lipton의 세 가지 모델 설명 가능성 수준(시뮬레이션 가능성, 분해 가능성, 알고리즘 설명 가능성)을 제시한다. 또한, 모델 자체에 내재된 논리를 설명하는 선행(ante-hoc) 설명과 외부 데이터나 모델을 사용하여 예측을 설명하는 후처리(post-hoc) 설명을 구분한다. 후처리 설명은 다시 모델 전체를 설명하는 전역적(global) 설명과 특정 입력에 대한 예측을 설명하는 국소적(local) 설명으로 나뉜다(Figure 1 참조). 좋은 설명은 반증 가능하고, 선택적이며, 인과적이고, 사회적이어야 한다는 특성을 가진다.

설명 가능성(explainability)은 이진 속성이 아니며 다양한 관점에서 접근할 수 있다. 논문은 Lipton의 세 가지 모델 설명 가능성 수준(시뮬레이션 가능성, 분해 가능성, 알고리즘 설명 가능성)을 제시한다. 또한, 모델 자체에 내재된 논리를 설명하는 선행(ante-hoc) 설명과 외부 데이터나 모델을 사용하여 예측을 설명하는 후처리(post-hoc) 설명을 구분한다. 후처리 설명은 다시 모델 전체를 설명하는 전역적(global) 설명과 특정 입력에 대한 예측을 설명하는 국소적(local) 설명으로 나뉜다(Figure 1 참조). 좋은 설명은 반증 가능하고, 선택적이며, 인과적이고, 사회적이어야 한다는 특성을 가진다.

모델 아키텍처 / 방법론

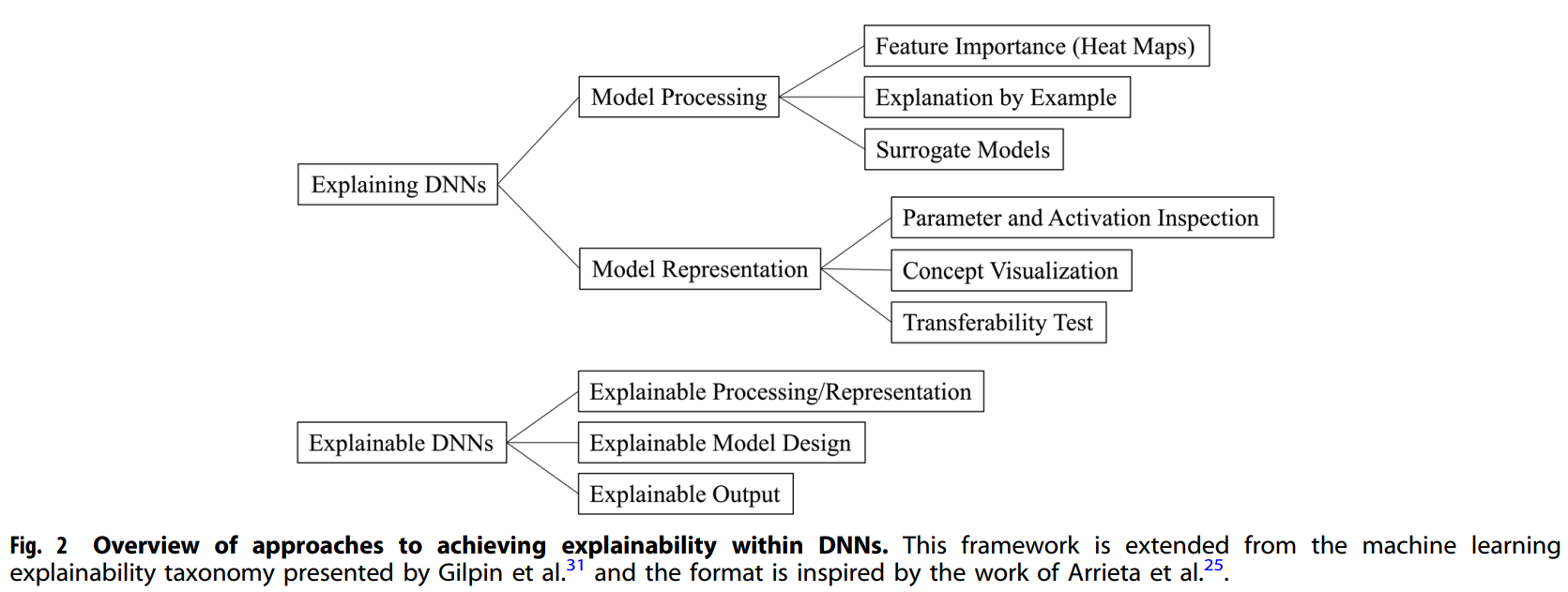

논문은 딥 뉴럴 네트워크(DNN)의 설명 가능성을 달성하기 위한 방법론을 크게 두 가지로 분류하여 제시한다(Figure 2 참조).

논문은 딥 뉴럴 네트워크(DNN)의 설명 가능성을 달성하기 위한 방법론을 크게 두 가지로 분류하여 제시한다(Figure 2 참조).

-

DNN 모델 처리 과정 설명:

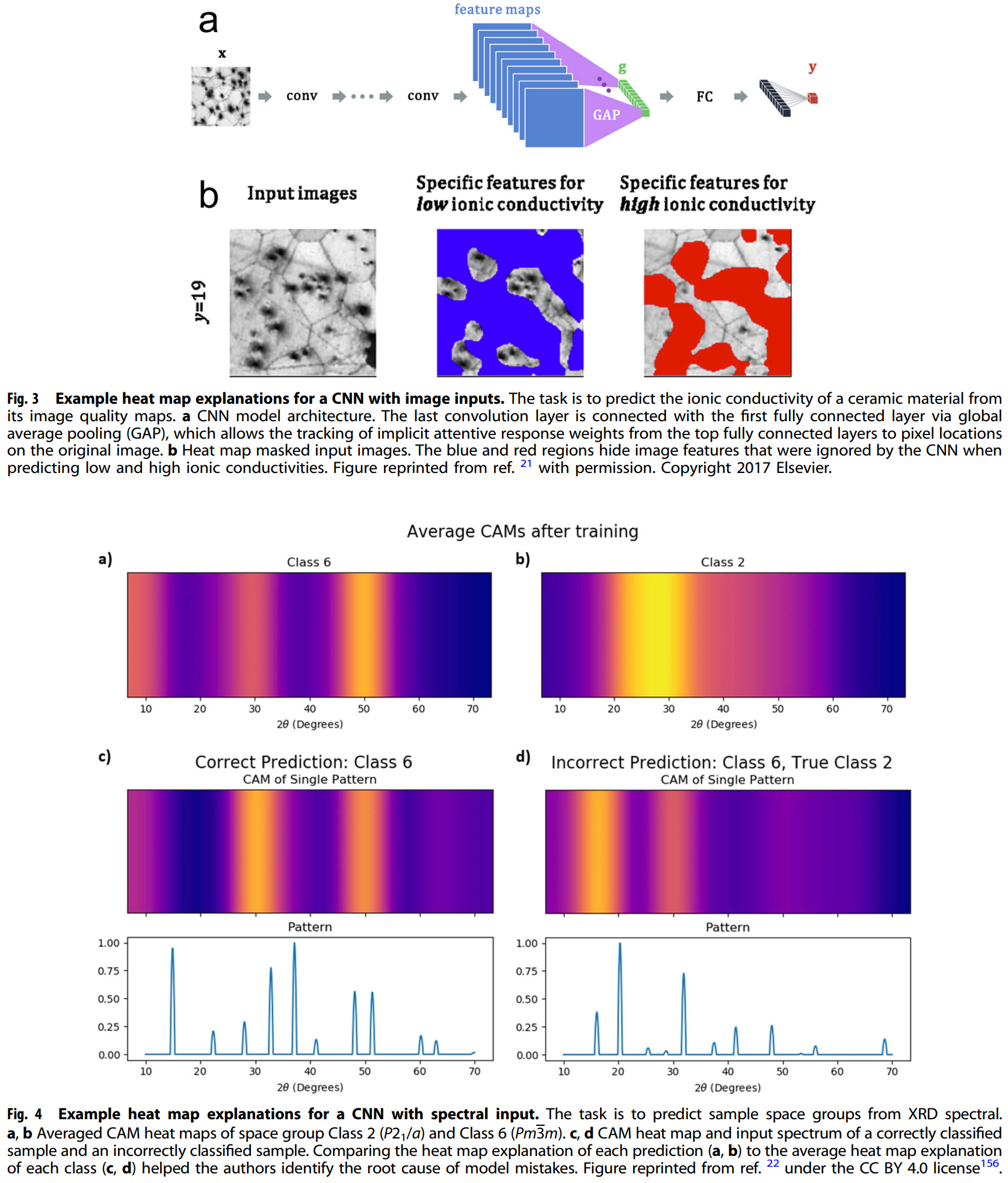

- 특징 중요도(히트맵): 모델이 입력 데이터를 어떻게 처리하는지 설명한다. 입력 데이터의 어떤 부분이 모델의 예측에 가장 중요했는지 보여주는 시각화 기법이다. 콘도(Kondo) 등의 연구는 CNN이 세라믹 재료의 이온 전도도를 예측할 때 공극(void)이 낮은 전도도와, 결함이 없는 영역이 높은 전도도와 관련이 있음을 히트맵을 통해 보여주었다(Figure 3). 오비에도(Oviedo) 등의 연구에서는 X-선 회절(XRD) 스펙트럼의 히트맵을 통해 모델의 오분류 원인이 데이터 불균형이나 혼합 상에 있음을 진단했다(Figure 4).

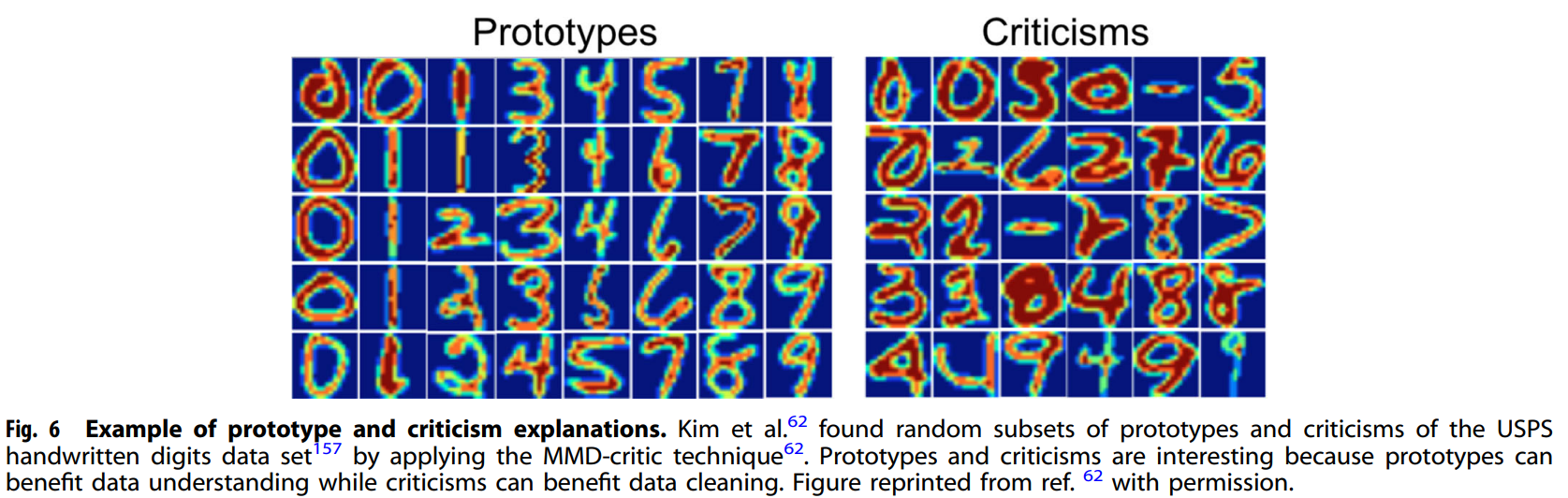

- 사례를 통한 설명: 모델의 예측을 훈련 데이터의 대표적인 예시를 들어 설명한다. 카일쿠라(Kailkhura) 등의 연구는 새로운 화합물을 예측할 때 훈련 데이터에서 가장 유사한 화합물을 참조하여 예측의 신뢰도를 높였다. 킴(Kim) 등의 연구는 MMD-critic 기술을 사용해 데이터셋에서 대표적인 '원형(prototype)'과 이상치인 '비판점(criticism)'을 식별하는 방법을 보여주었다(Figure 6).

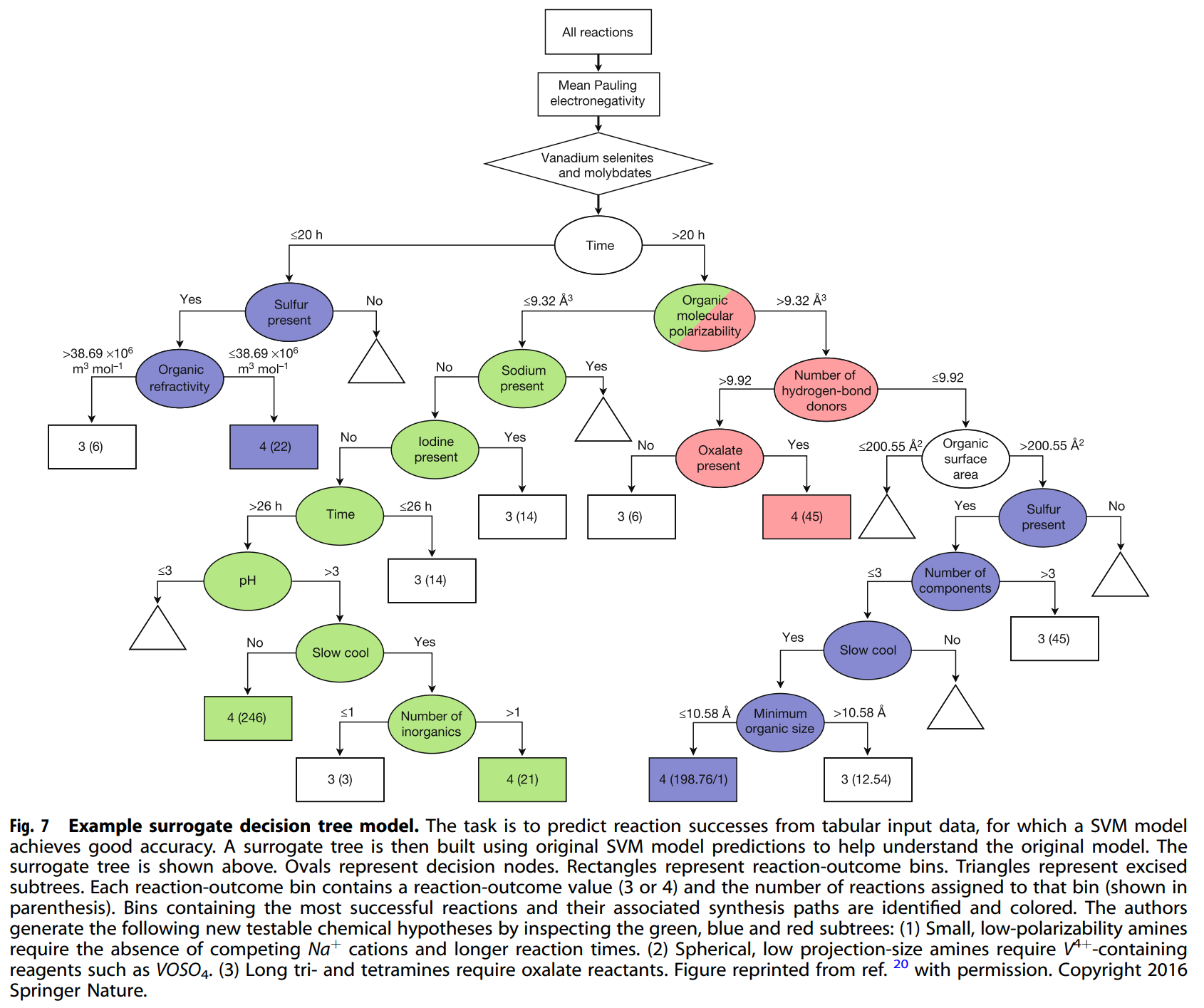

- 대리 모델(Surrogate Models): 원본 블랙박스 모델과 유사하게 동작하지만, 더 단순하고 설명하기 쉬운 모델을 구축하여 설명한다. 라쿠글리아(Raccuglia) 등의 연구는 SVM 모델의 예측을 설명하기 위해 의사결정 나무를 대리 모델로 사용해 새로운 화학적 가설을 도출했다(Figure 7).

- 특징 중요도(히트맵): 모델이 입력 데이터를 어떻게 처리하는지 설명한다. 입력 데이터의 어떤 부분이 모델의 예측에 가장 중요했는지 보여주는 시각화 기법이다. 콘도(Kondo) 등의 연구는 CNN이 세라믹 재료의 이온 전도도를 예측할 때 공극(void)이 낮은 전도도와, 결함이 없는 영역이 높은 전도도와 관련이 있음을 히트맵을 통해 보여주었다(Figure 3). 오비에도(Oviedo) 등의 연구에서는 X-선 회절(XRD) 스펙트럼의 히트맵을 통해 모델의 오분류 원인이 데이터 불균형이나 혼합 상에 있음을 진단했다(Figure 4).

-

DNN 모델 표현 설계:

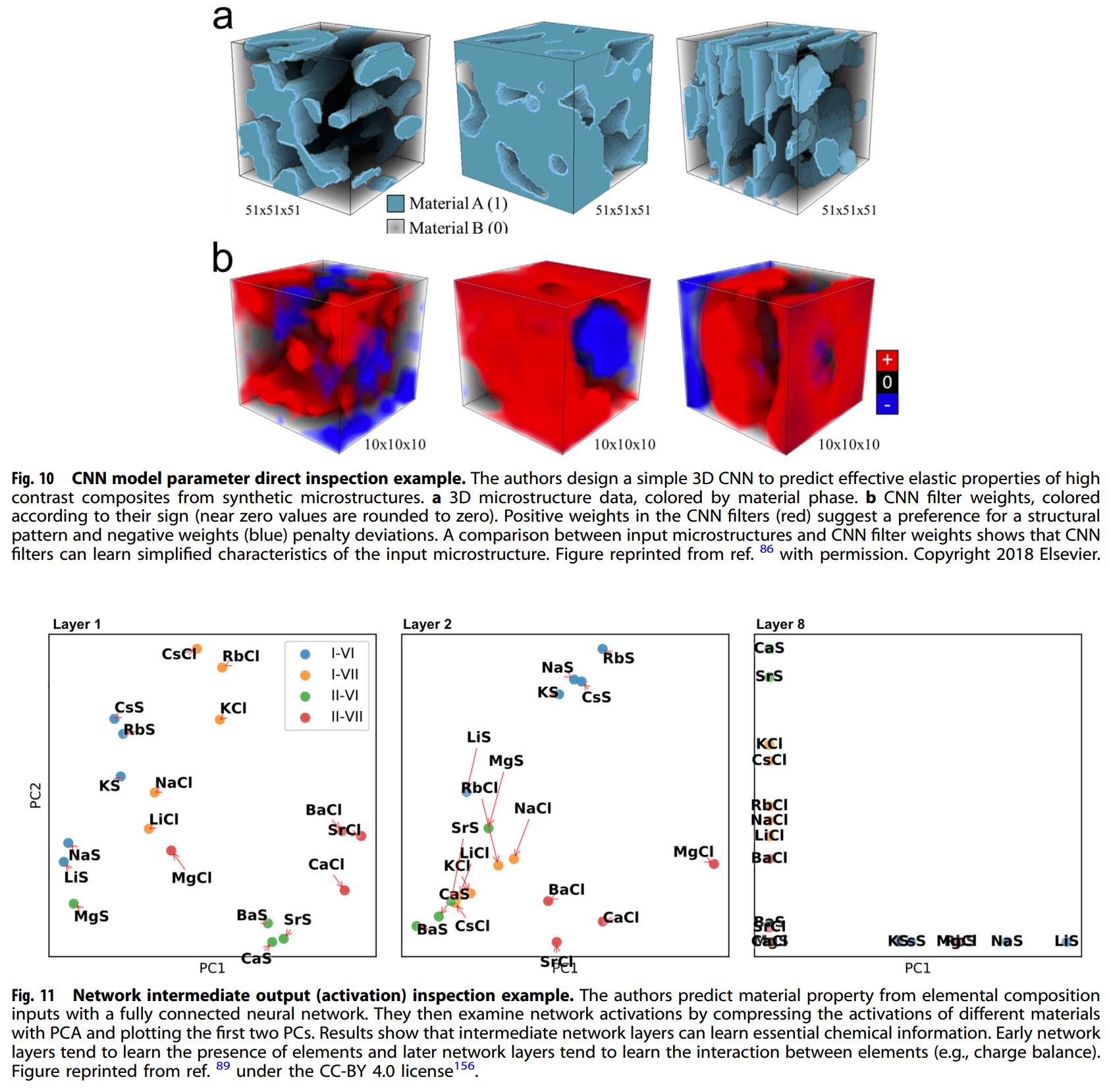

- 파라미터 및 활성화 검사: 모델의 파라미터(가중치)나 중간 계층의 활성화 값을 직접 검사하여 모델이 학습한 정보를 이해한다. 세센(Cecen) 등의 연구는 3D CNN 필터가 재료 미세 구조의 물리적으로 의미 있는 패턴을 학습했음을 보여주었다(Figure 10). 자(Jha) 등의 연구는 ElemNet의 중간 계층 활성화 분석을 통해 모델이 원소 구성 정보로부터 복잡한 화학적 상호작용을 계층적으로 학습했음을 보여주었다(Figure 11).

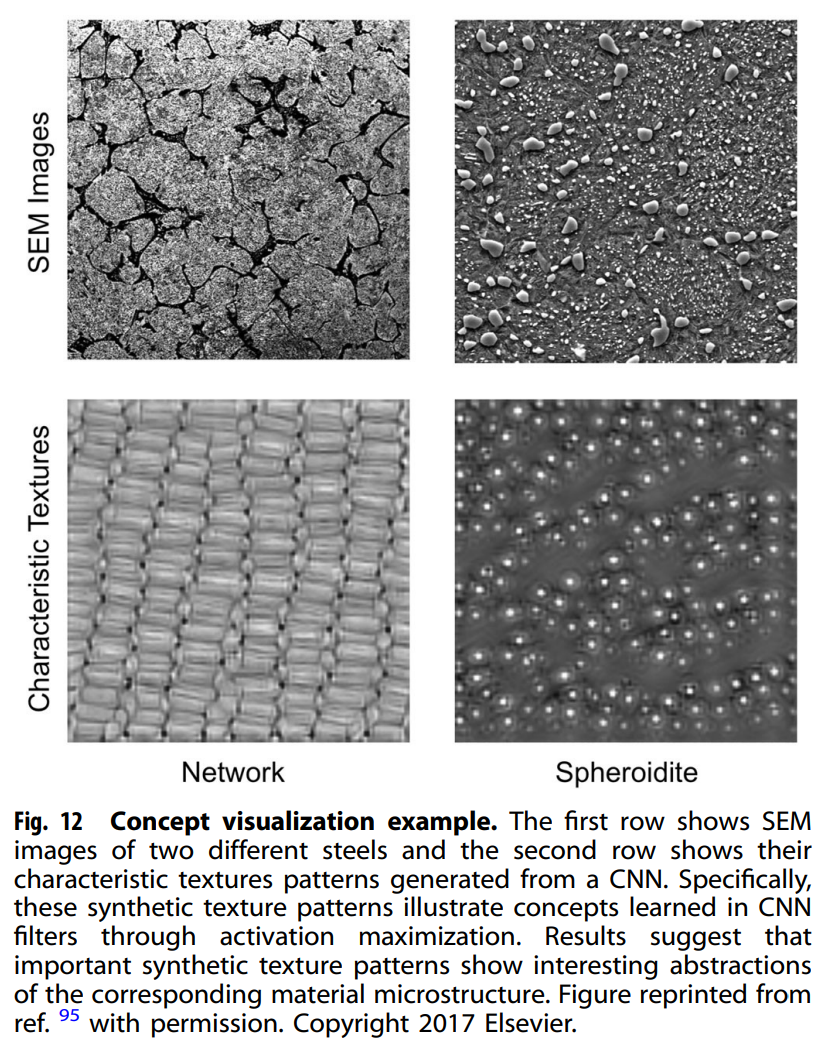

- 개념 시각화: 모델의 특정 부분이 어떤 개념에 반응하는지 보여주는 원형(prototypical) 입력 이미지를 생성한다. 링(Ling) 등의 연구는 활성화 최대화(activation maximization)를 통해 CNN 필터가 학습한 미세 구조의 특징적인 텍스처를 시각화했다(Figure 12).

- 전이 가능성 테스트: 한 작업에서 훈련된 모델의 계층을 다른 작업에 재사용하여 모델의 학습 내용이 다양한 작업에 유용함을 증명한다.

- 파라미터 및 활성화 검사: 모델의 파라미터(가중치)나 중간 계층의 활성화 값을 직접 검사하여 모델이 학습한 정보를 이해한다. 세센(Cecen) 등의 연구는 3D CNN 필터가 재료 미세 구조의 물리적으로 의미 있는 패턴을 학습했음을 보여주었다(Figure 10). 자(Jha) 등의 연구는 ElemNet의 중간 계층 활성화 분석을 통해 모델이 원소 구성 정보로부터 복잡한 화학적 상호작용을 계층적으로 학습했음을 보여주었다(Figure 11).

-

설명 가능한 DNN 설계:

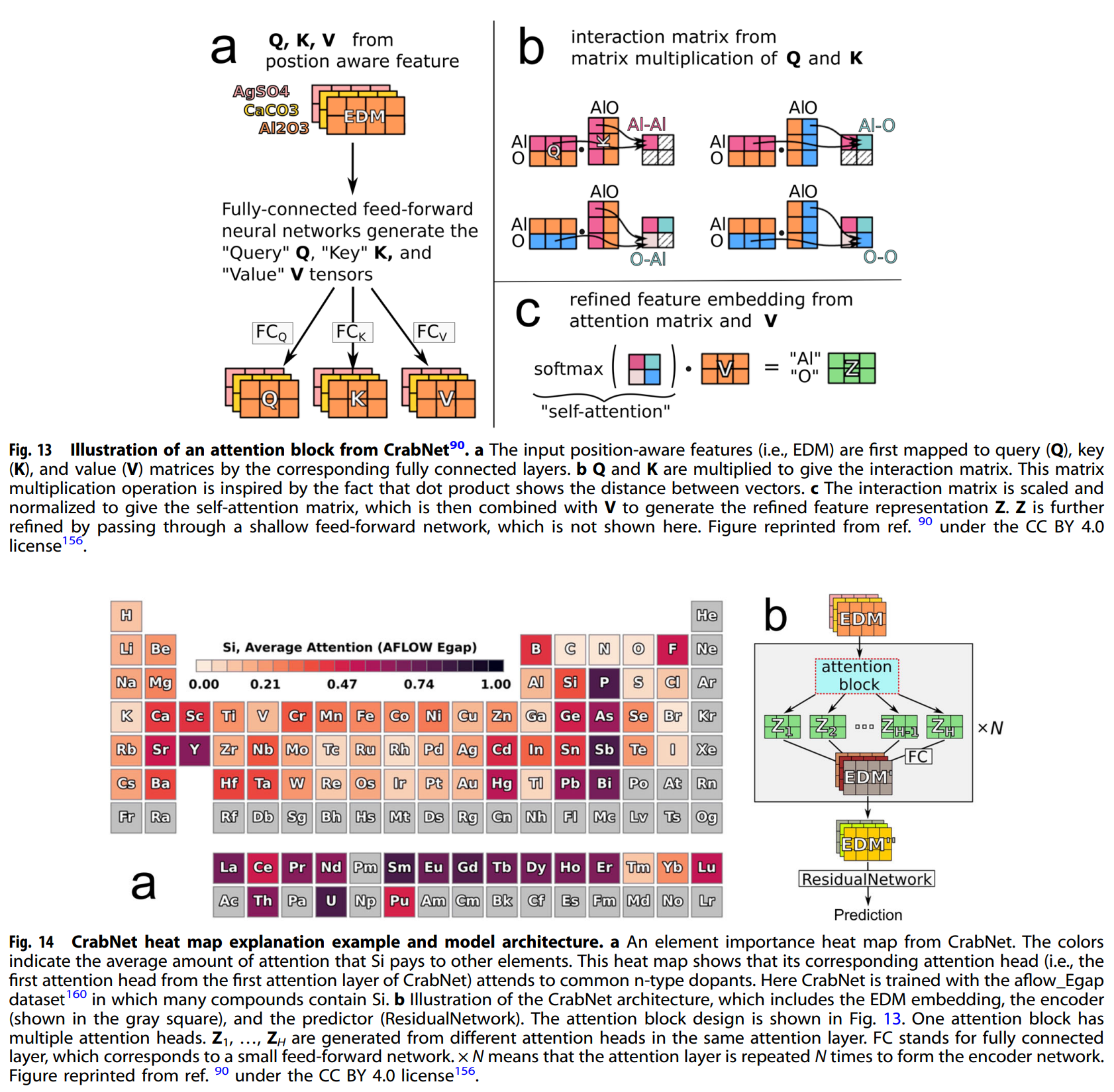

- 설명 가능한 처리/표현: 트랜스포머(Transformer)와 같은 모델은 자기-주의(self-attention) 메커니즘을 통해 본질적으로 설명 가능성을 제공한다. 크랩넷(CrabNet)은 이러한 자기-주의 메커니즘을 재료 예측에 적용하여 화학 공식으로부터 물질 특성을 예측하고, 원소 간의 상호작용 중요도를 히트맵으로 제공한다(Figure 13, 14).

- 설명 가능한 모델 설계: 재료과학 도메인 지식을 네트워크 설계에 통합하여 모델의 예측 과정을 더 직관적으로 만든다. SchNet은 원자 시스템의 기본 단위인 원자와 원자 간의 상호작용을 네트워크 구조에 반영하여 물리적 이해를 돕는다.

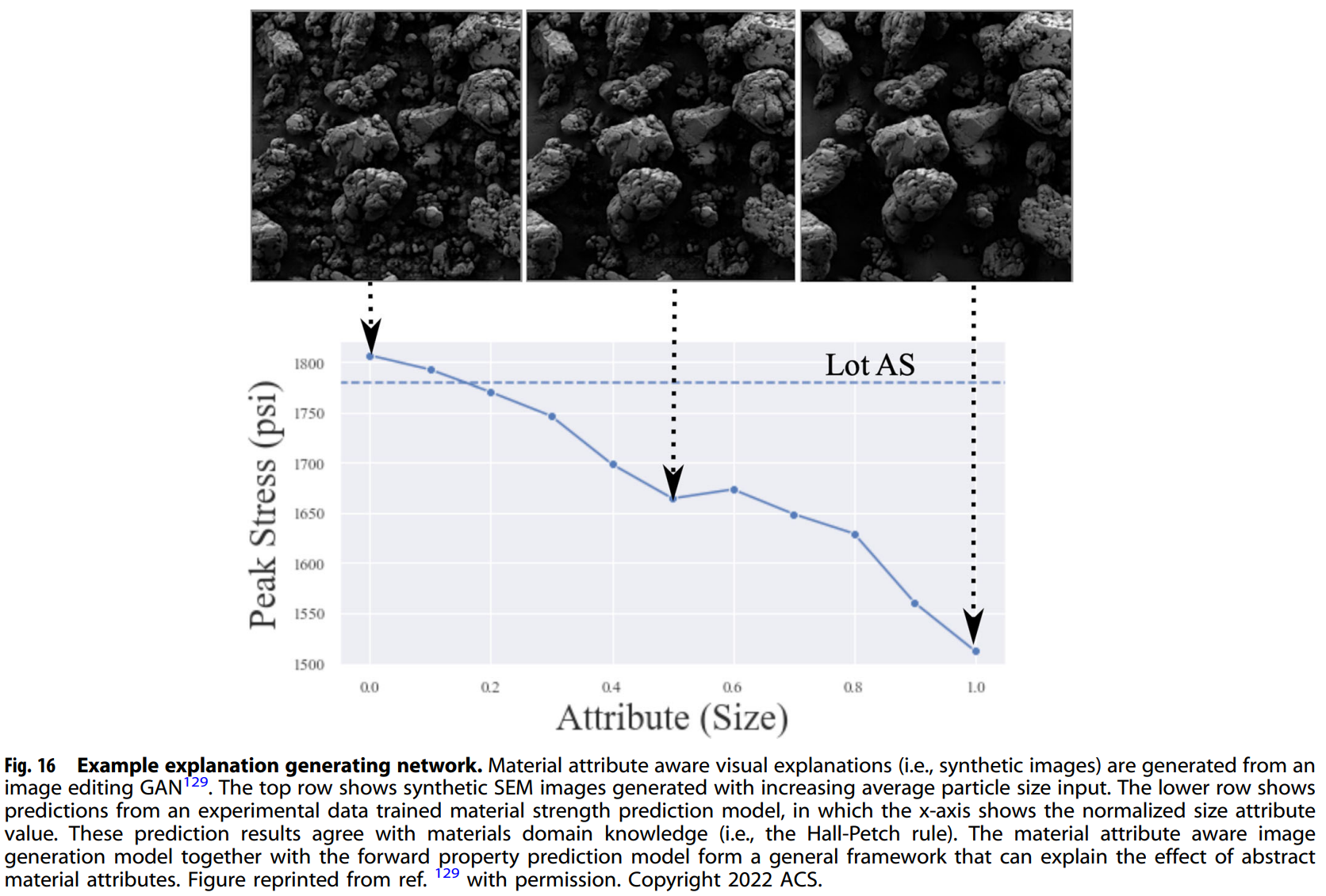

- 설명 가능한 출력: 모델의 내부 동작은 복잡해도 출력이 물리적으로 의미 있는 형태로 제공될 수 있다. 홀스태드(Holstad) 등의 연구는 LSTM 오토인코더를 사용하여 페로 전기 재료의 복잡한 측정 신호를 물리적으로 의미 있는 구성 요소로 분해했다. 리우(Liu) 등의 연구는 GAN을 사용해 입자 크기나 기공과 같은 재료 속성을 조작한 합성 이미지를 생성하여 Hall-Petch 규칙과 같은 물리 법칙을 시각적으로 설명했다(Figure 16).

실험 결과

논문은 별도의 실험을 수행하지 않고, 기존 연구 사례를 중심으로 XAI의 효과를 입증한다.

- 주요 데이터셋: 재료과학 분야의 다양한 데이터셋(SEM 이미지, XRD 스펙트럼, 화합물 구성 데이터 등)을 활용한 사례를 제시한다.

- 핵심 성능 지표: 주로 모델 예측의 정확도 외에, XAI를 통해 얻을 수 있는 통찰력(예: 히트맵을 통한 물리적 현상 확인, 대리 모델을 통한 새로운 가설 생성)을 중요하게 다룬다.

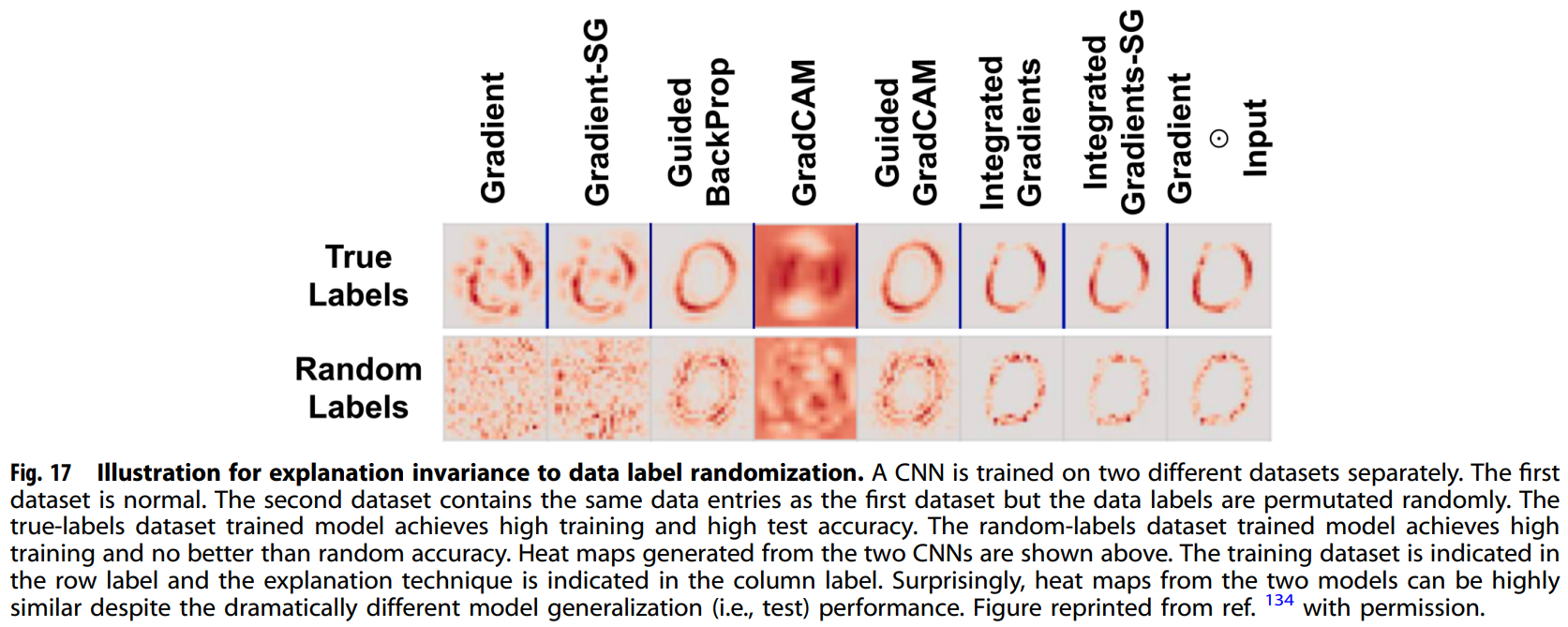

- 비교 결과: 아데바요(Adebayo) 등의 연구 사례를 통해 일부 히트맵 기법이 모델 파라미터에 민감하지 않음을 보여주며, 설명 기법 자체에 대한 신뢰성 평가가 중요함을 강조한다(Figure 17).

결론

이 논문은 재료과학에서 XAI의 중요성과 잠재력을 강조하며, 기존 머신러닝 모델의 신뢰성 문제와 과학적 통찰력 부족 문제를 해결할 수 있는 다양한 기술적 접근법을 제시한다. 그러나 재료과학 데이터의 특수성(명확한 정답 부재, 통계적 분포의 중요성) 때문에 기존 XAI 기술을 그대로 적용하는 데 어려움이 있음을 지적한다. 논문은 향후 연구 기회로 도메인 지식을 통합한 설명 가능 모델 개발, 설명에 대한 엄격한 평가 기준 마련, 그리고 재료과학에 특화된 XAI 도구 라이브러리 구축 등을 제안한다. 이는 재료과학 커뮤니티가 머신러닝을 단순한 예측 도구에서 벗어나 새로운 과학적 발견을 위한 핵심적인 파트너로 활용하는 데 중요한 방향성을 제시한다.