IEMOTIONS-FACS

1. 얼굴 표정 분석 기본 사항

1.1. 얼굴 표정(Facial expressions)이란 무엇인가?

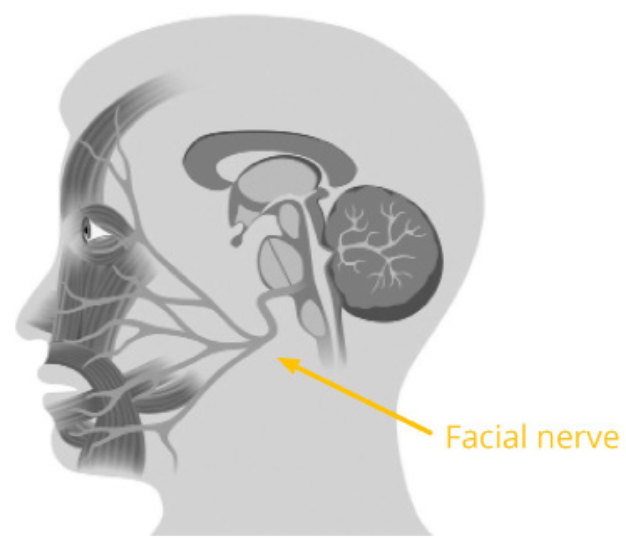

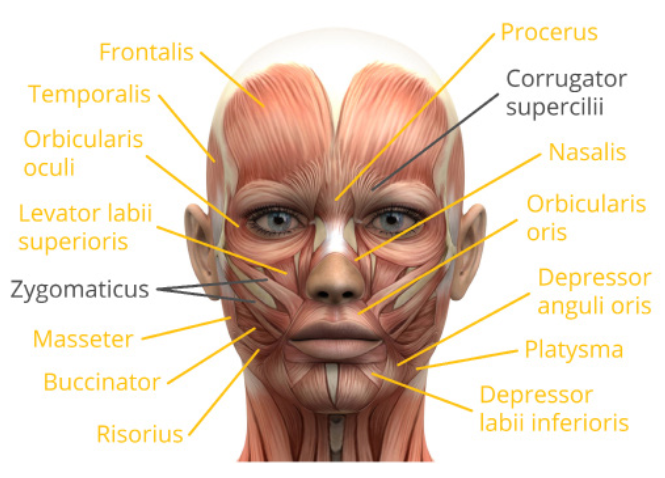

얼굴은 40개 이상의 구조적, 기능적으로 자율적인 근육을 포함하는 복잡한 신호 시스템이다. 얼굴 근육 시스템은 신체에서 유일하게 근육이 뼈와 얼굴 조직, 또는 얼굴 조직에만 부착된 곳이다.(다른 신체 근육은 두 개의 뼈에 연결됨) 이러한 구조는 표현을 위해 고도로 전문화되어 있으며, 언어적 및 비언어적 의사소통을 가능하게 한다.

대부분의 얼굴 근육은 단 하나의 신경, 즉 얼굴 신경(Facial nerve)에 의해 제어된다.(예외: 위쪽 눈꺼풀은 동안 신경(oculomotor nerve)이 지배)

신경 연결은 양방향이며, 뇌 신호에 따라 근육 수축을 유발하고(뇌-근육), 현재 근육 상태 정보를 뇌로 다시 전달한다(근육-뇌).

신경 연결은 양방향이며, 뇌 신호에 따라 근육 수축을 유발하고(뇌-근육), 현재 근육 상태 정보를 뇌로 다시 전달한다(근육-뇌).

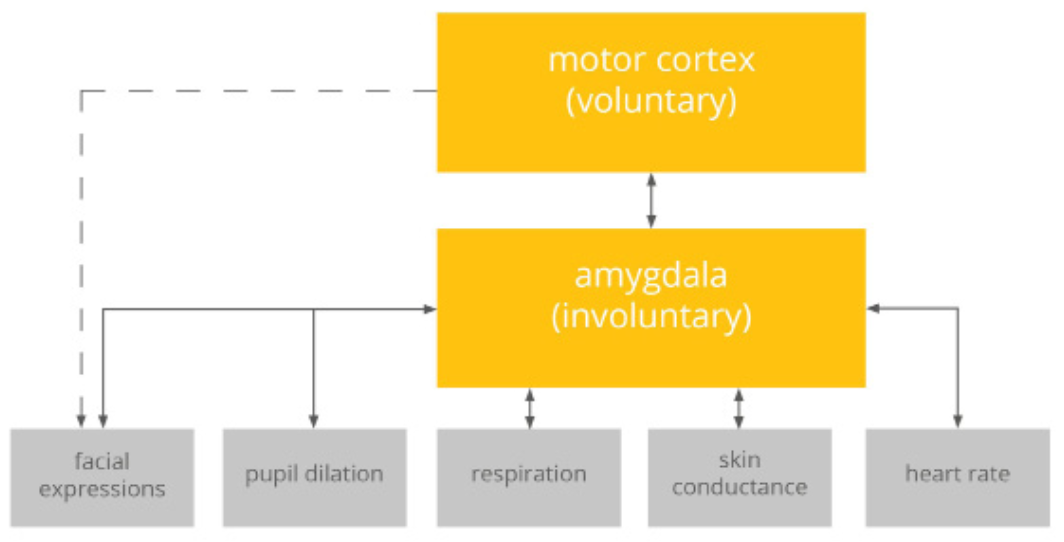

얼굴 표정은 불수의적(involuntary) 표정과 수의적(voluntary) 표정으로 나뉜다.

- 불수의적 표정: 뇌간(brainstem)에 의해 제어되며, 자발적이고 무의식적으로 발생한다.

- 수의적 표정: 운동 피질(motor cortex)이 관여하며, 의식적으로 제어되고 의도적인 표정이다. 이 때문에 가짜 미소(수의적)는 진짜 미소(불수의적)만큼 자연스럽게 보이지 않는다.

1.2. 얼굴 표정과 감정(Emotions)

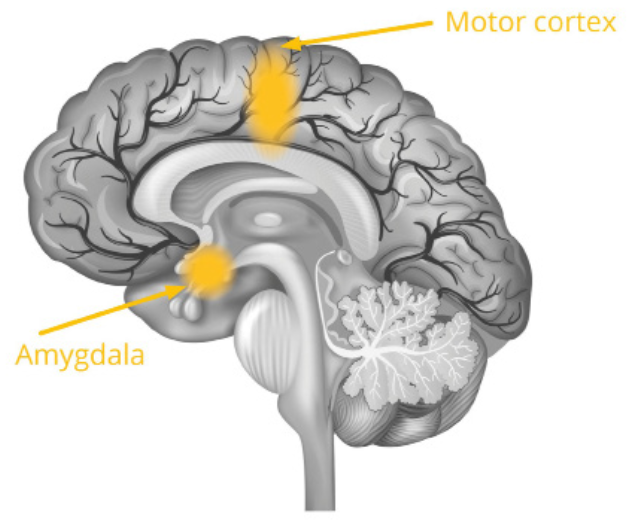

얼굴 표정을 유발하는 뇌간 영역은 감정 처리 및 조절도 제어한다.

특히 편도체(Amygdala)는 시각적 또는 청각적 위협에 직면했을 때 활성화되며, 감정적 각성(emotional arousal)을 제어한다.

편도체는 코르티솔과 같은 스트레스 호르몬 방출을 조절하고, 심박수, 피부 전도도, 호흡 및 얼굴 표정과 같은 관찰 가능한 행동을 제어한다.

편도체는 코르티솔과 같은 스트레스 호르몬 방출을 조절하고, 심박수, 피부 전도도, 호흡 및 얼굴 표정과 같은 관찰 가능한 행동을 제어한다.

얼굴 피드백 가설(Facial feedback hypothesis) Fritz Strack의 1988년 연구에 따르면, 얼굴 표정과 감정은 밀접하게 얽혀 있다. 참가자들이 펜을 이빨로 물어 미소를 짓는 근육을 활성화했을 때(입술로만 물었을 때보다) 만화를 더 유머러스하게 평가했다. 이는 얼굴 근육의 선택적 활성화 또는 억제가 자극에 대한 감정적 반응에 강한 영향을 미친다는 것을 시사한다.

감정, 느낌, 기분(Emotions vs. Feelings vs. Moods)

- 감정(Emotions): 특정 자극에 의해 유발되는 복잡한 행동 프로그램. 신체 증상(심박수 증가), 행동 경향(투쟁-도피), 얼굴 표정, 인지 평가를 포함한다.

- 느낌(Feelings): 감정적 행동 프로그램에 대한 주관적인 인식. 의식적인 생각과 성찰에 의해 주도된다. 감정 없이는 느낌을 가질 수 없다.

- 기분(Moods): 감정보다 덜 강하고 상당히 오래 지속되는 확산된 내부 주관적 상태.

감정 분류 수천 개의 얼굴 표정이 가능하지만, 성별, 나이, 문화와 상관없이 거의 모든 사람이 특정 감정과 연관 짓는 7가지 보편적인(universal) 감정이 있다.

- Joy(기쁨)

- Anger(분노)

- Surprise(놀람)

- Fear(두려움)

- Contempt(경멸)

- Sadness(슬픔)

- Disgust(혐오감)

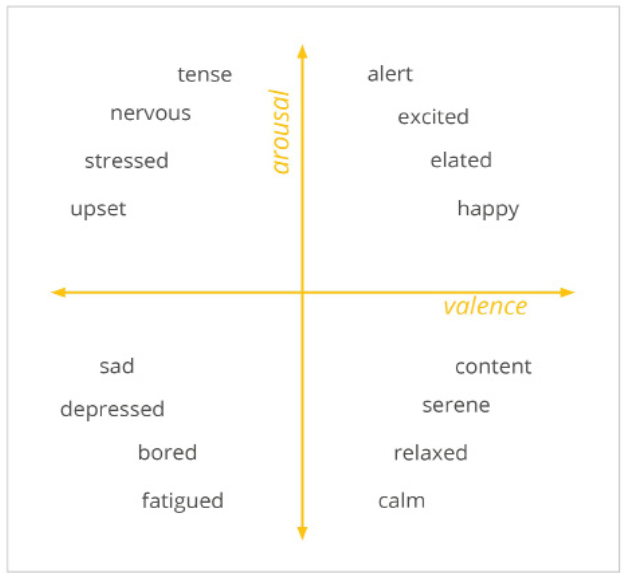

감정을 구별하는 두 가지 주요 이론이 있다.

- 이산 감정 이론(Discrete emotion theory): 7가지 기본 감정은 상호 배타적이며 각각 다른 행동 프로그램, 얼굴 표정, 생리적 과정을 가진다고 가정한다.

- 차원 모델(Dimensional models): 감정이 두 개 이상의 차원을 따라 배열될 수 있다고 가정한다. 가장 일반적인 모델은 Valence(긍정 vs. 부정)를 수평축으로, Arousal(활성 vs. 진정)을 수직축으로 사용한다.

1.3. 적용 분야

얼굴 표정 분석은 감정적 각성과 얼굴 반응을 유발하는 모든 콘텐츠, 제품 또는 서비스를 테스트하는 데 사용될 수 있다.

- 소비자 신경과학 및 뉴로마케팅: 자기 보고서의 한계를 보완하여 제품이나 서비스에 대한 무의식적인 감정 반응을 정량화한다.

- 미디어 테스트 및 광고: TV 광고, 예고편 등에서 의도한 감정 반응(예: 미소)이 나타나는지, 또는 원치 않는 부정적 표정(혐오, 혼란)이 나타나는지 식별한다.

- 심리학 연구: 자극 속성(색상, 모양)과 사회적 기대가 성격 특성 및 학습 이력에 따라 얼굴 표정에 어떤 영향을 미치는지 평가한다.

- 임상 심리학 및 심리 치료: 자폐 스펙트럼 장애(ASD), 우울증 환자 등 자신의 표정을 조절, 처리, 해석하는 데 장애가 있는 집단을 모니터링한다.

- 의료 적용 및 성형 수술: 안면 신경 마비(Bell's Palsy 등)의 악화 정도를 정량화하고 수술 및 재활 치료의 성공 여부를 평가한다.

- 소프트웨어 UI 및 웹사이트 디자인: 테스터가 웹사이트나 소프트웨어를 탐색하는 동안 좌절이나 혼란(예: 미간 찌푸림)을 모니터링한다.

- 인공적 사회 행위자(아바타) 엔지니어링: 인간 사용자의 감정 상태를 감지하고 유연하게 반응하는 인공 지능을 개발한다.

1.4. 얼굴 표정 분석 기술

얼굴 표정은 세 가지 주요 방식으로 수집 및 분석된다.

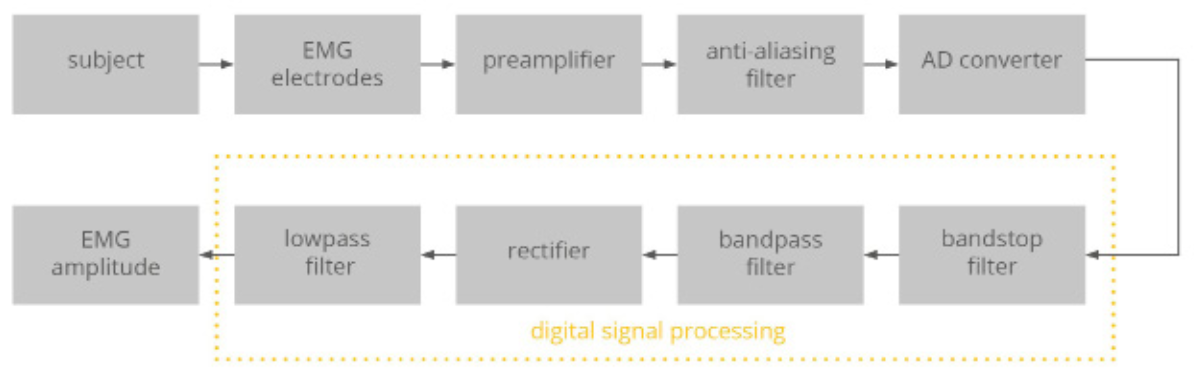

1. 얼굴 근전도(Facial Electromyography, fEMG) 피부 표면에 부착된 전극으로 얼굴 근육의 활동을 추적한다. 근육 섬유가 수축할 때 발생하는 미세한 전기 임펄스를 감지하고 증폭한다.

- 주요 측정 부위:

- Corrugator supercilii(눈썹 주름근): 미간을 찌푸리는 것(부정적 감정)과 관련됨.

- Zygomaticus major(큰광대근): 입꼬리를 당겨 미소(긍정적 감정)를 짓는 것과 관련됨.

- 장점: 매우 미묘한 근육 활동도 측정할 수 있는 정밀하고 민감한 방법이다.

- 단점: 전극, 케이블이 필요하여 침습적이며, 전문가의 처리 기술이 필요하다. ![PDF p.15: fEMG 신호 처리 파이프라인 다이어그램]

2. 수동 코딩(FACS)

Paul Ekman과 Wallace V. Friesen이 1978년에 개발한 Facial Action Coding System(FACS)는 전문가가 얼굴 행동을 객관적으로 코딩하는 표준화된 분류 시스템이다.

FACS는 감정을 감지하는 것이 아니라, 얼굴 표정의 발생을 기본 구성 요소인 Action Units(AUs)의 조합으로 기술하는 측정 시스템이다.

각 AU는 개별 얼굴 근육 또는 근육 그룹에 해당하며 번호(예: AU1, AU2)로 식별된다.

- 표정 카테고리:

- Macroexpressions: 0.5초에서 4초간 지속되며, 일상적인 상호작용에서 맨눈으로 쉽게 관찰된다.

- Microexpressions: 0.5초 미만으로 지속되며, 감정을 의식적/무의식적으로 숨기려 할 때 나타난다.

- Subtle expressions: 감정의 강도와 관련되며, 표정이 약하게 시작되는 것을 나타낸다.

- 장점: 비침습적이며 객관적이고 신뢰할 수 있다.

- 단점: 전문가의 훈련과 코딩에 엄청난 시간과 비용이 소요된다.(1분 비디오 코딩에 약 100분 소요)

3. 자동 얼굴 표정 분석(Automatic facial expression analysis) 컴퓨터 비전 알고리즘을 사용하여 자동으로 분석한다.(다음 장에서 상세 설명)

2. 얼굴 표정 분석 시작하기

2.1. 기술(Technology)

최신 컴퓨터 비전 및 기계 학습 알고리즘을 채택한 자동 안면 코딩(Automatic facial coding) 절차가 개발되었다. 이 기술은 노트북, 태블릿, 휴대폰의 내장 카메라나 웹캠을 사용하여 응답자의 얼굴 비디오를 캡처한다.

자동 안면 코딩의 기술적 단계

- 얼굴 감지(Face detection): 비디오 프레임에서 얼굴의 위치를 찾는다.(예: Viola-Jones 알고리즘)

- 특징 감지(Feature detection): 감지된 얼굴 내에서 눈, 눈썹, 입꼬리, 코끝 등 주요 얼굴 랜드마크를 감지한다. 보이지 않는 가상 메쉬가 응답자의 얼굴 움직임을 따라간다.

- 특징 분류(Feature classification): 주요 특징들의 위치 및 방향 정보를 분류 알고리즘에 입력하여 Action Unit 코드, 감정 상태 등으로 변환한다.

주요 엔진으로는 Emotient FACET, Affectiva AFFDEX, Noldus FaceReader 등이 있으며, 각각 제공하는 측정 항목(예: 기본 감정, Action Units 수, Valence 등)에 차이가 있다.

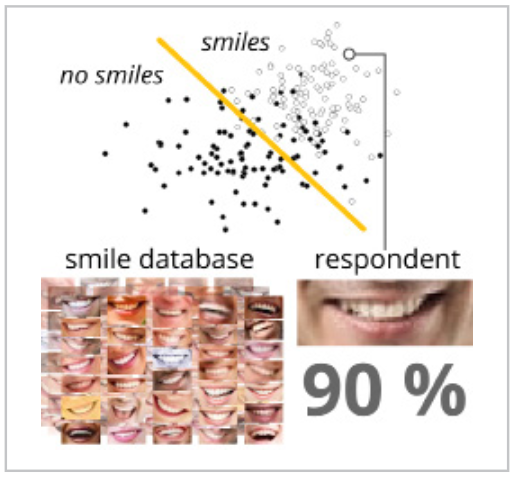

분류는 통계적 데이터베이스와의 비교를 통해 이루어진다.

엔진은 응답자의 현재 표정(예: 입꼬리 올라간 정도)을 데이터베이스의 통계 및 규범적 분포와 수치적으로 비교한다.

이 과정은 결정론적(Yes/No)이 아니며, 해당 표정이 특정 감정(예: 미소)일 가능성(likelihood)을 확률적 결과(예: 90%)로 반환한다.

분류는 각 감정, AU별로 독립적으로 수행된다.

분류는 각 감정, AU별로 독립적으로 수행된다.

2.2. 장비(Equipment)

온라인 자동 안면 코딩(웹캠)

- 렌즈: 표준 렌즈 사용(광각 또는 어안 렌즈 지양).

- 해상도: 엔진마다 최소 요구 사항이 다르나, HD나 4K까지는 필요 없다.

- 프레임레이트: 초당 10프레임(fps) 이상의 안정적인 프레임레이트.

- 자동 초점(Autofocus): 응답자 얼굴을 추적할 수 있는 기능이 필요하다.

- 조명: 조명 조건에 따라 프레임레이트가 동적으로 변하는 카메라는 피해야 한다.(Logitech HD Pro C920 권장)

오프라인 자동 안면 코딩(기존 비디오 파일)

- 해상도: 최소 640x480 픽셀 권장.

- 프레임레이트: 10fps 이상 권장.

- 비디오 코덱: MP4, WMV 등 표준 코덱 지원.

2.3. 응답자 지시(Respondent instruction)

- 카메라 배치: 응답자의 눈높이에, 얼굴이 프레임 중앙에 정면으로 오도록 배치한다.(약 ±20도 각도 허용)

- 조명: 실내의 균일하고 확산된 조명(간접 조명)이 가장 좋다. 역광이나 강한 직사광선(강한 그림자 유발)을 피해야 한다.

- 얼굴 가시성: 눈썹, 눈, 코, 입과 같은 주요 랜드마크가 가려지지 않아야 한다.

- 피해야 할 것: 과도하게 큰 뿔테 안경, 선글라스, 입을 가리는 수염, 얼굴 피어싱, 모자, 얼굴을 가리는 헤어스타일.

- 주의: 응답자가 손으로 얼굴을 가리거나 머리를 괴지 않도록 지시한다.

- 말하기, 먹기, 마시기: 이 활동들은 입 주변 근육을 움직여 감정 분류에 오류를 일으킬 수 있다.(예: 말하는 움직임을 감정으로 오인)

- 실험 전 충분히 먹고 마시도록 권장하며, 특히 껌을 씹는 것은 절대 금물이다.

2.4. 자극 설정(Stimulus setup)

Baseline(기저선) 실행 일부 엔진은 분석 시작 전(약 5~10초) 응답자의 "중립적인" 얼굴 표정을 수집하는 Baseline 기간을 요구한다.

- Neutral baseline: 자극 없이 편안하게 카메라를 응시하며 중립적인 표정을 기록한다.

- Variable stimuli baseline: 중립, 긍정, 부정 감정을 유발하는 다양한 장면을 포함하는 자극을 제시하여 응답자의 표정 스펙트럼(최대치)을 기록한다.

자극 제시 얼굴 표정은 자극 제시 후 수십~수백 밀리초 내에 매우 빠르게 반응한다. 자극은 응답자가 내용을 처리할 수 있도록 충분히 길게 제시해야 한다. 자극 사이에 표정이 중립(baseline) 상태로 돌아갈 수 있도록 적절한 길이의 "냉각" 자극(예: 회색 화면)을 배치하는 것이 유용하다.

- IAPS(International Affective Picture System): 감정 및 주의 연구를 위해 특별히 고안된 1,000여 장의 표준화된 사진 데이터베이스.

2.5. 데이터 출력 및 시각화

자동 분석은 표정, AU, 감정에 대한 숫자 점수(Confidence score)를 반환한다.(보통 0에서 100)

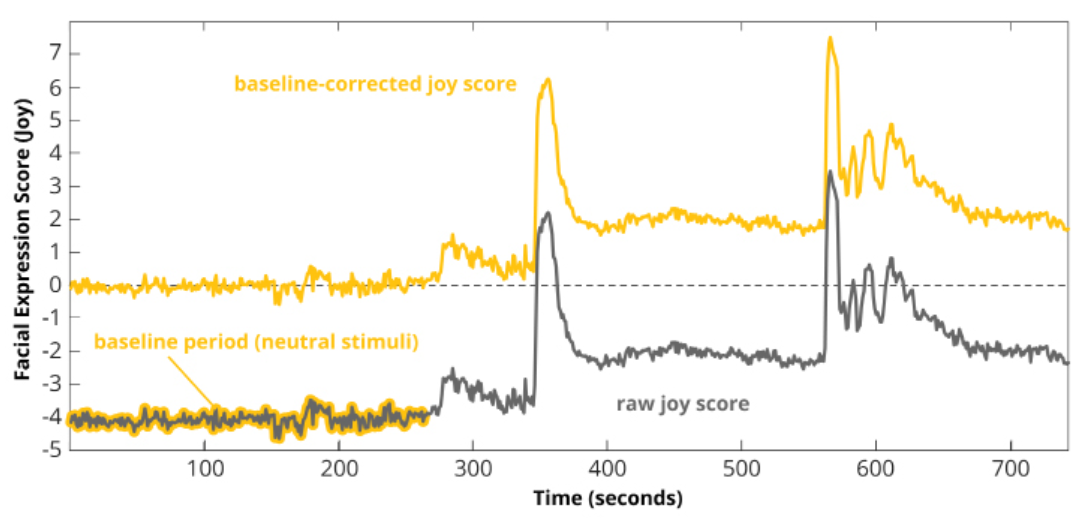

Raw scores vs. Baseline-corrected scores

- Raw score: 엔진의 글로벌 데이터베이스와 비교한 원시 분류 결과. 여러 응답자나 그룹 간 비교에 유용하다.

- Baseline-corrected score: 응답자 개인의 중립 표정(baseline)을 고려하여 보정한 값.

- (계산: Baseline 기간의 중앙값(median)을 계산하여, 전체 샘플에서 해당 값을 뺀다.)

- 개인별 변화(예: 훈련 경과)를 볼 때 유용하다.

Thresholding(임계값 설정) 미묘한 표정(noise)을 걸러내고 의미 있는 강한 표정만 분석하기 위해 컷오프 기준을 정의한다.

- 시간 기반(Thresholding in time): 특정 표정이 최소한의 시간(예: 0.5초) 동안 지속되어야 분석에 포함한다. 짧은 "폭발"을 무시한다.

- 진폭 기반(Amplitude-based thresholding): 특정 표정이 최소한의 진폭(강도)을 넘어야 분석에 포함한다.

- 절대적 임계값(Absolute thresholds): 0-100 중 특정 값(예: 50)을 하드코딩하여 기준점으로 삼는다.

- 상대적 임계값(Relative thresholds): 응답자 데이터 분포의 백분위수(예: 상위 20%인 80번째 백분위수)를 기준점으로 삼는다. 응답자마다 실제 기준 점수는 달라진다.

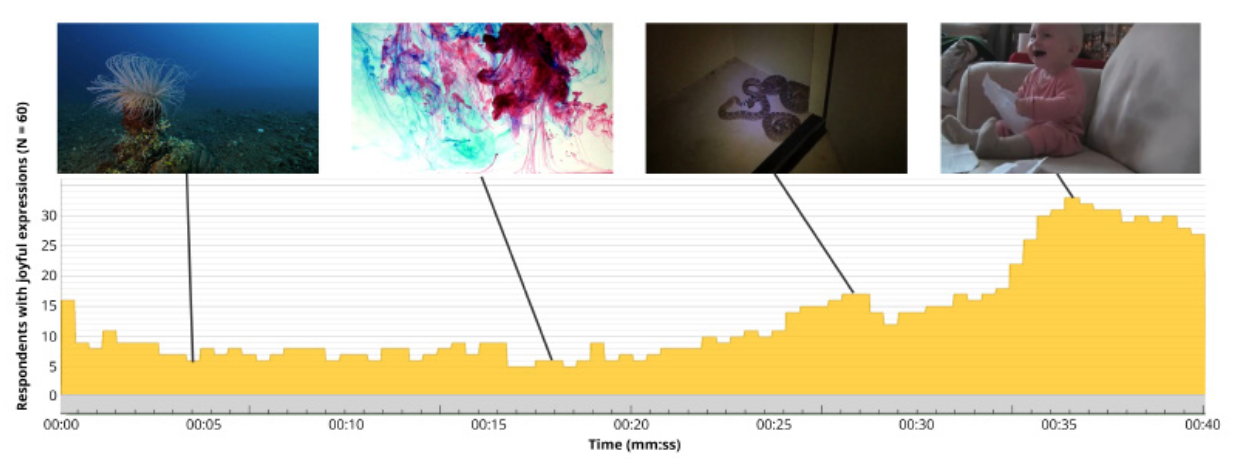

데이터 집계(Aggregation)

여러 응답자의 데이터를 집계하여 청중의 일관된 반응을 시각화할 수 있다.

- 각 응답자의 연속 데이터를 짧은 시간 간격(예: 500ms)으로 나눈다.

- 각 창(window) 내의 중앙값을 계산한다.

- 이 값이 설정된 임계값을 초과하면 1(True), 아니면 0(False)을 할당한다(Binarization).

- 각 시간 간격마다 모든 응답자의 이진 점수(0 또는 1)를 합산한다.

- (예: 10명 중 10명이 임계값을 넘으면 합계 10, 아무도 넘지 못하면 0)

- 결과 곡선은 자극에 의해 유발된 청중의 감정적 일관성(arousal)을 보여준다.

3. 얼굴 표정 분석 재장전

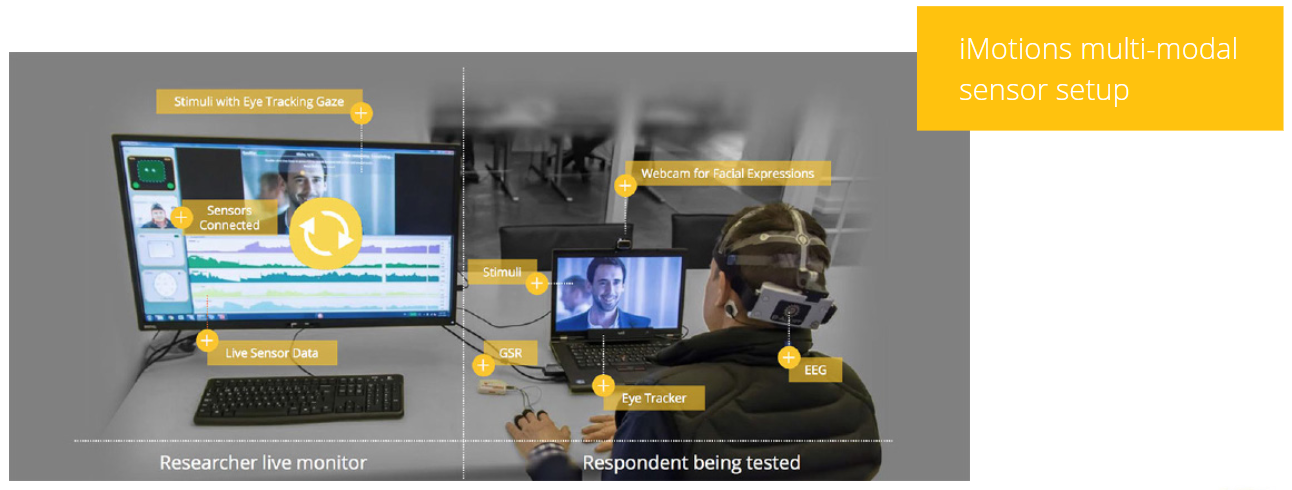

3.1. 생체 인식 센서 추가(Multimodal Research)

컴퓨터 기반 안면 코딩은 감정 반응의 질(quality), 즉 Valence(긍정/부정)는 잘 측정하지만, 감정의 강도(intensity)인 Arousal(각성)을 평가하는 데는 한계가 있다. (예: 어떤 사람은 공포 영화를 보며 비명을 지르지만, 어떤 사람은 무표정하게 보지만 속으로는 똑같이 무서워할 수 있다.) 감정적 참여를 완벽하게 파악하려면 Valence와 Arousal을 모두 평가해야 하며, 이때 다중 모드 연구(multimodal research)가 필요하다.

Arousal 측정을 위한 주요 바이오마커

- Eye tracking(시선 추적): 시선 위치뿐만 아니라 동공 팽창(pupil dilation)을 추적한다. 스트레스 상황이나 각성시키는 자극에 노출되면 동공이 팽창하며, 이는 의식적으로 제어할 수 없다.

- GSR/EDA(피부 전기 활동): 피부의 땀샘에서 분비되는 땀의 양을 반영한다. 감정적 자극(흥분, 스트레스)에 노출되면 손, 발, 이마에서 "감정적인 땀"이 나며 피부 전도성이 높아진다.

- EEG(뇌파): 두피 표면에서 뇌의 전기적 활동을 측정한다. 시간 해상도가 가장 높으며, 참여, 동기 부여, 좌절, 인지 부하 등과 관련된 뇌 역학을 밝혀낸다.(미소는 속일 수 있어도 뇌는 속일 수 없다.)

- EMG(근전도): 얼굴 외 신체 부위(예: 손가락)의 근육 반응을 모니터링한다.(예: 놀람 반사)

- ECG/PPG(심전도/광용적맥파): 심박수(Heart rate)를 추적하여 신체 상태, 불안 및 스트레스 수준(각성)에 대한 통찰력을 얻는다.

얼굴 표정 분석을 Eye tracking, GSR, EEG 등과 결합하면 감정 반응의 Valence(질)와 Arousal(강도) 모두에 대한 통찰력을 얻을 수 있다.

3.2. iMotions를 통한 분석

iMotions Biometric Research Platform은 연구 설계, 다중 센서 보정, 데이터 수집 및 분석을 위한 소프트웨어 솔루션이다.

얼굴 표정 분석, GSR, Eye tracking, EEG, ECG/EMG 등 50개 이상의 주요 생체 인식 센서를 하나의 플랫폼에서 동기화하고 지원한다.

iMotions는 개별적으로 코딩된 얼굴 표정 데이터를 집계하는 혁신적인 절차(앞서 2.5에서 설명한 집계 방식)를 제공하여 청중의 반응 일관성을 파악하는 데 도움을 준다.

iMotions는 개별적으로 코딩된 얼굴 표정 데이터를 집계하는 혁신적인 절차(앞서 2.5에서 설명한 집계 방식)를 제공하여 청중의 반응 일관성을 파악하는 데 도움을 준다.